有机搜索已成为我们日常生活中不可或缺的一部分。最近的数据显示,近30% 的全球网络流量来自在线搜索。 搜索引擎每天抓取和索引数十亿的网络内容,根据相关性(它们与搜索查询的相关程度)在搜索结果中对它们进行排名,从而使它们可供公众使用。您可以使用 robot.txt 文件设置有关您希望搜索引擎如何抓取和向公众显示您的 Web 内容的指令。本文将向您介绍您需要了解的有关 robots.txt 文件的所有信息。

了解 Robot.txt 文件

搜索索引从简单的搜索引擎抓取开始。robots.txt 文件,也称为Robots Exclusion Protocol ,指示搜索机器人抓取网站——去哪里和不去哪里。用户经常使用该文件来指定搜索引擎不应抓取的页面。

当搜索引擎通过链接或站点地图发现网站时,它会打开网站的 robots.txt 文件以了解要抓取的页面和不应该抓取的页面。爬虫会缓存 robots.txt 文件,以免每次访问网站时打开它。缓存文件每次自动刷新数次,定期保持更新。

robots.txt 区分大小写并位于域的根目录下,例如www.domain.com/robots.txt。

为什么 Robots.txt 文件很重要

为您的网站创建一个 robot.txt 文件有很多好处;例如,您可以使用它来管理您的抓取预算。搜索蜘蛛通常有预定数量的可以在网站上抓取的页面或在网站上花费的时间。如果您管理一个拥有数千个页面的网站,您可以阻止不重要的页面以最大化抓取预算。

使用 robots.txt 文件的其他好处包括:

- 它可以帮助网络管理员控制搜索引擎可以访问的网页。

- 该文件使用户可以完全自由地阻止特定机器人抓取他们的网站。

- 该文件有助于防止敏感内容被编入索引。

- 您可以使用它来阻止索引不必要的文件,例如图像、PDF 和视频。

使用 Robots.txt 文件提高可抓取性

现在,如何使用 robots.txt 文件提高网站的可抓取性?当然,让我们找出答案。

Robots.txt 语法

机器人文件包含一个或多个搜索引擎指令块,第一行指定用户代理——您向其提供爬行指令的搜索蜘蛛的名称。

基本的 robots.txt 文件如下所示:

站点地图:https://yourdomain.com/sitemap_index.xml

用户代理: *

不允许:/*?comments=all

不允许:/wp-content/themes/user/js/script-comments.js

不允许:/wp-comments-post.php

不允许:/go/

用户代理:Googlebot

不允许:/登录

用户代理:bingbot

不允许:/照片

上面的 robots.txt 文件包含三个指令块——第一个指令是针对所有用户代理的,第二个指令是针对Google 爬虫的,第三个是针对 Bing 机器人的。

以下是这些术语的含义:

- Sitemap指定了网站站点地图的位置,它列出了一个网站中的所有页面,方便爬虫查找和爬取。您还可以将站点地图放在 robots.txt 文件的末尾。

- 如前所述,用户代理指的是您希望向其发送指令的搜索机器人。使用星号 (*) 通配符将指令分配给所有用户代理,但您可以使用正确的名称指定用户代理。

- Disallow指示用户代理不抓取指定的 URL。您可以将该行留空以指定您不允许任何内容。

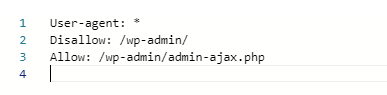

Allow指令指示机器人抓取指定的URL,即使先前的指令不允许其目录,下面是一个示例。

用户代理: *

不允许:/wp-admin/

允许:/wp-admin/admin-ajax.php

robots.txt 文件阻止了wp-admin目录,该目录包含敏感的 WordPress 文件,包括插件和主题,但允许蜘蛛爬行和索引目录中的admin-ajax.php文件。

crawl-delay指令 ( crawl-delay: 10 ) 告诉用户代理在抓取页面之前等待指定的秒数(例如,十秒)。

该指令告诉搜索引擎更改抓取页面的频率,从而帮助您节省带宽。不幸的是,Google 不再识别该指令,但 yahoo 和 Bing 仍然识别。

用户代理指令

大多数搜索引擎都有不同的爬虫用于不同的目的。例如,一些搜索引擎有用于正常索引、图像和视频的蜘蛛,而像 Bing 这样的一些搜索引擎甚至有用于他们的广告程序的蜘蛛。

因此,我们按字母顺序整理了一张目前可用的所有常见用户代理的表格。

让我们来看看。

| 序列号 | 搜索引擎 | 机器人类型 | 用户代理 |

| 1 | 百度 | 一般索引 | 百度蜘蛛 |

| 2 | 百度 | 图片 | 百度蜘蛛图片 |

| 3 | 百度 | 移动索引 | baiduspider-mobile |

| 4 | 百度 | 消息 | 百度蜘蛛新闻 |

| 5 | 百度 | 影片 | 百度蜘蛛视频 |

| 6 | Bing | 一般的 | 冰棒 |

| 7 | Bing | 一般的 | 微信机器人 |

| 8 | Bing | 图片和视频 | 微软媒体 |

| 9 | Bing | 广告 | adidxbot |

| 10 | 谷歌 | 一般的 | 谷歌机器人 |

| 11 | 谷歌 | 图片 | Googlebot 图片 |

| 12 | 谷歌 | 移动的 | Googlebot-移动版 |

| 13 | 谷歌 | 消息 | Googlebot-新闻 |

| 14 | 谷歌 | 视频 | Googlebot-视频 |

| 15 | 谷歌 | AdSense | Mediapartners-谷歌 |

| 16 | 谷歌 | 广告 | AdsBot - 谷歌 |

| 17 | 雅虎 | 一般的 | 啜饮 |

| 18 | Yandex | 一般的 | yandex |

用户代理区分大小写,因此在设置 robots.txt 文件时请正确使用名称。

设置抓取指令

让我们探讨一些可以使用 robots.txt 文件无缝抓取网站的方法。

抓取整个网站

您可以设置 robots.txt 文件以允许所有搜索机器人对您的整个网站进行爬网和索引。如果您的网站上有私人或敏感文件,我们不建议这样做。

但是,要提供此指令,请将以下行添加到您的 robots.txt 文件中。

用户代理: *

不允许:

但是如果你希望只允许选定的蜘蛛爬行和索引整个网站,那么指定用户代理,当然,每个用户代理一个指令块。

阻止整个网站

为防止搜索引擎抓取您的网站并将其编入索引,尤其是在您重新设计网站时,您可以阻止整个网站被编入索引。 将此指令添加到您的 robots.txt 文件以完成它。

用户代理: *

不允许: /

为防止机器人抓取您的网站,请指定用户代理。

阻止选定的部分

要阻止网站的特定部分,请为文件夹或页面设置禁止指令,这是一个示例。

用户代理: *

不允许:/视频

该指令阻止所有蜘蛛抓取视频目录及其中的所有内容。您还可以使用通配符 (*) 和 ($) 等正则表达式来阻止文件组。不幸的是,大多数搜索引擎不识别后者,包括谷歌。

但是这里介绍如何使用正则表达式来阻止一组文件。

不允许:图片/*.jpg

不允许:/*php $

通配符 (*) 阻止图像目录中文件名中包含.jpg的文件,而 ($) 阻止所有以.php结尾的文件。

请注意,disallow、allow 和 user-agent 值区分大小写。在我们上面的两个例子中,搜索蜘蛛将阻止:

- 视频目录,但不会阻止/videos

- /images/beach.jpg但会抓取/images/beach.JPG

Robot.txt 文件对比。无索引标签

robots.txt 文件指示蜘蛛不要抓取页面,但如果许多网站链接它,可能不会阻止搜索引擎索引该页面。如果搜索引擎发现足够多的指向该页面的外部链接,它会在不知道其内容的情况下对该页面进行索引,从而为您提供如下所示的搜索结果:

![]()

但是您可以将Noindex 指令添加到您的 robots.txt 文件中,以防止这些文件出现在搜索结果中。

用户代理: *

不允许:/视频

无索引:/视频

您还可以将 meta robots noindex标记添加到页面的标题中,以可靠地防止搜索引擎对其进行索引。如果您使用此选项,请避免阻止带有 robots.txt 的页面以使蜘蛛程序能够找到标签。

生成 Robot.txt 文件

您可以使用一些直观的在线工具为您的网站生成一个 robots.txt 文件,这里只有五个:

- 早上的 Robots.txt 生成器

- SureOak Robots.txt 文件生成器

- SEOptimer 免费 Robots.txt 生成器

- SEO PowerSuite Robots.txt 生成器工具

- SEOBook Robots.txt 文件生成器

将 Robots.txt 文件添加到您的域

您可以通过帐户控制面板将新创建的 robots.txt 添加到您的域,方法如下。

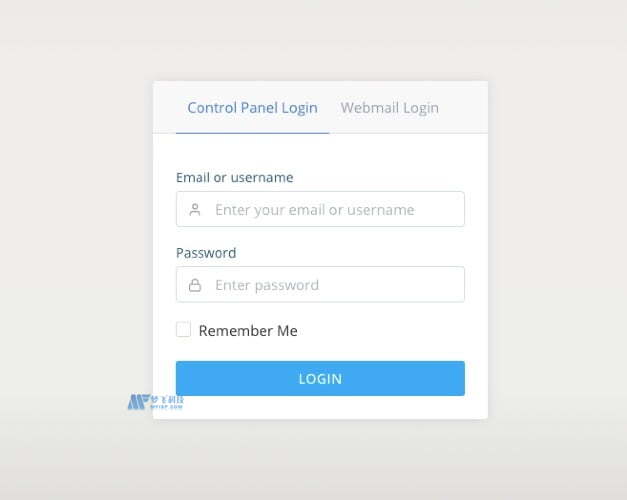

第 1 步:访问您的帐户控制面板

通过登录 SPanel 访问您帐户的控制面板。访问www.domain.com/spanel/login ,将domain.com替换为您的域名。

输入您的登录凭据以登录。

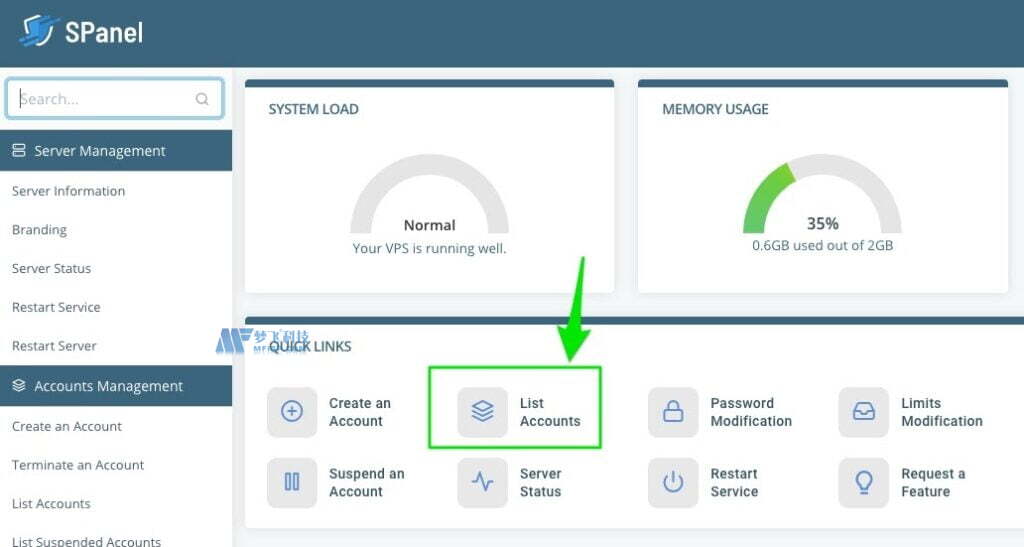

如果您以管理员身份登录,则 SPanel 会将 您带到您的管理仪表板,但用户访问会将您登录到控制面板。在管理仪表板上,滚动到QUICK LINKS并单击List Accounts 。

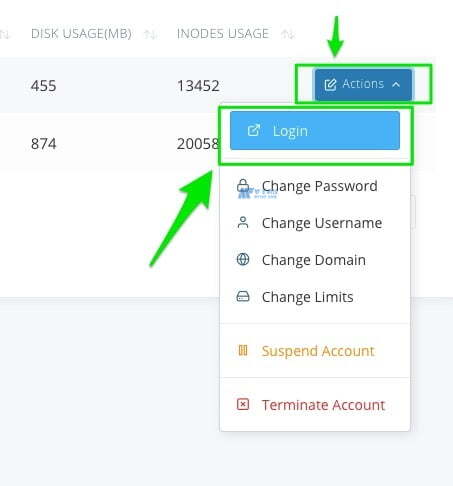

单击您希望访问其控制面板的帐户的“操作”按钮,然后从上拉菜单中选择“登录”以获取访问权限。

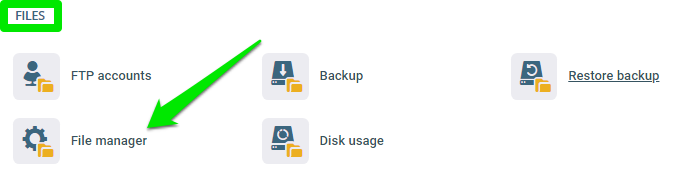

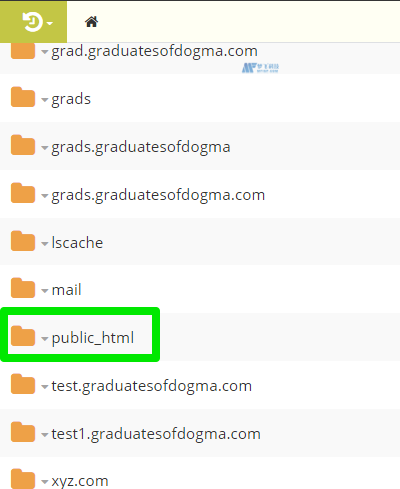

第 2 步:打开文件管理器

在控制面板上,单击文件部分下的文件管理器。

打开您网站的基本目录或根目录。根域使用public_html文件夹作为其根目录。

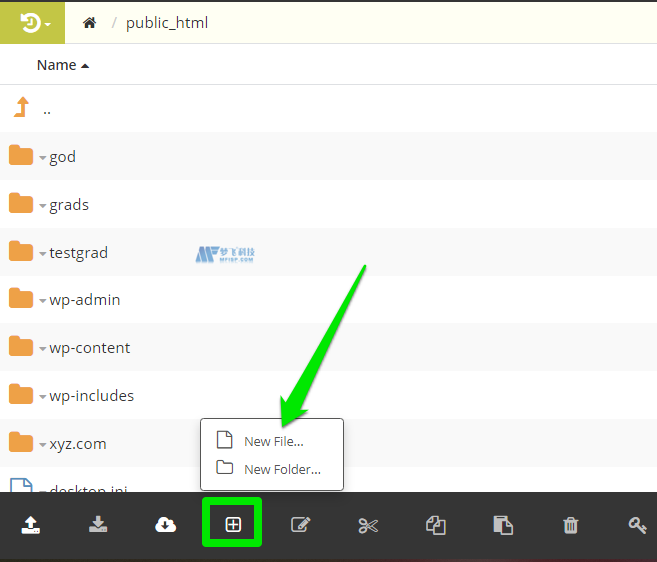

第 3 步:创建 Robots.txt 文件

在根目录中,单击新建文件/文件夹图标并选择新建文件。

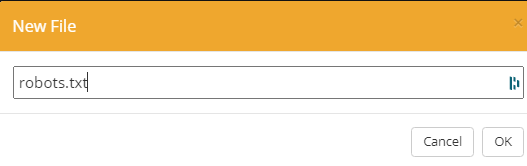

将新文件命名为robots.txt不带大写,然后单击确定保存

编写您的爬网指令或将它们复制并粘贴到空白文件中并保存。

而已。

把它包起来

当您发布 robots.txt 文件时,请使用Google robots.txt 测试器工具来验证抓取指令,以确保您不会错误地禁止您不打算阻止的页面。