在全球互联网的背后,服务器的带宽扮演着关键的角色。持续增长的数据流量和用户需求使得服务器带宽成为美国作为信息技术重要中心的关注焦点。本文将探讨美国服务器带宽的限制和管理方式,揭示背后的挑战和应对策略。

带宽限制:

服务器带宽是指服务器与外部网络之间的数据传输速度。美国的服务器带宽面临以下限制:

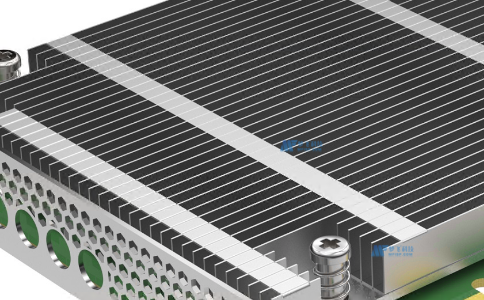

1. 物理网络设备:服务器带宽受到物理设备的限制,包括路由器、交换机和网络电缆等。随着技术的发展,网络设备的性能和带宽容量不断提高,但仍然存在物理限制。

2. 运营商限制:服务器供应商或数据中心通常与运营商合作,通过网络服务提供商(ISP)获得带宽。运营商可能会对带宽进行限制,以管理网络拥塞和资源分配。

带宽管理:

为了更好地管理带宽资源,美国采取了多种管理方式:

1. 带宽分配:数据中心或服务器供应商会根据客户需求和合同约定,分配特定的带宽给每个服务器。这确保了每个客户都可以获得一定的带宽资源,避免了单个客户占用过多资源而影响其他用户的使用体验。

2. 流量调整:ISP可能会根据网络拥塞情况对流量进行调整,采取限制或优先级控制策略来分配带宽。这可以根据实时情况对不同类型的流量进行优化,确保关键任务和重要数据的顺利传输。

3. 带宽升级:随着需求的增长,数据中心和服务器供应商会定期评估并升级他们的带宽容量。这可以通过增加硬件设备、更换更高性能的网络设备或与更多的运营商合作来实现。

挑战和应对策略:

美国服务器带宽管理面临一些挑战:

1. 数据增长:随着大数据和云计算的兴起,数据流量不断增长。服务器带宽需要不断扩容和升级以应对不断增长的需求。

2. 网络拥塞:特定时间段或区域的网络拥塞可能会导致带宽不足,影响网络性能。对于这些挑战,可以采取负载均衡、网络优化和流量监控等策略来应对。

总结:

美国服务器带宽的限制和管理是一个复杂的问题。通过带宽分配、流量调整和升级等策略,数据中心和服务器供应商努力确保带宽资源的合理使用和高效管理。随着技术的发展和需求的不断增长,美国持续探索更先进的解决方案来满足日益增长的数据流量和用户需求,以确保网络的稳定性和性能提升。